部署yolov11训练点选验证码

1 本地环境安装

注意:因为部分图片是我用的笔记本截图的,所以可能有点模糊。

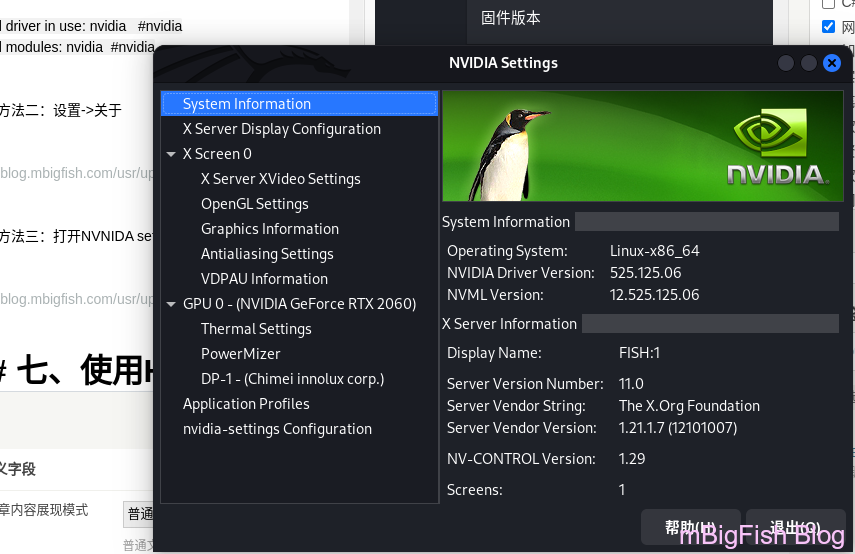

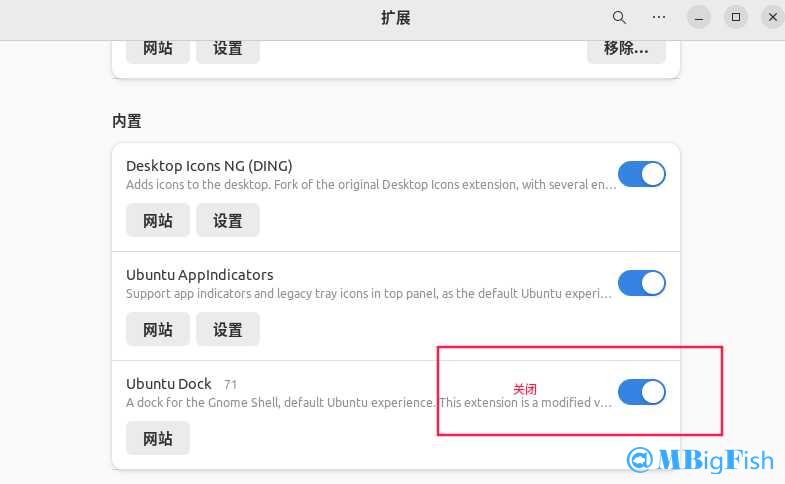

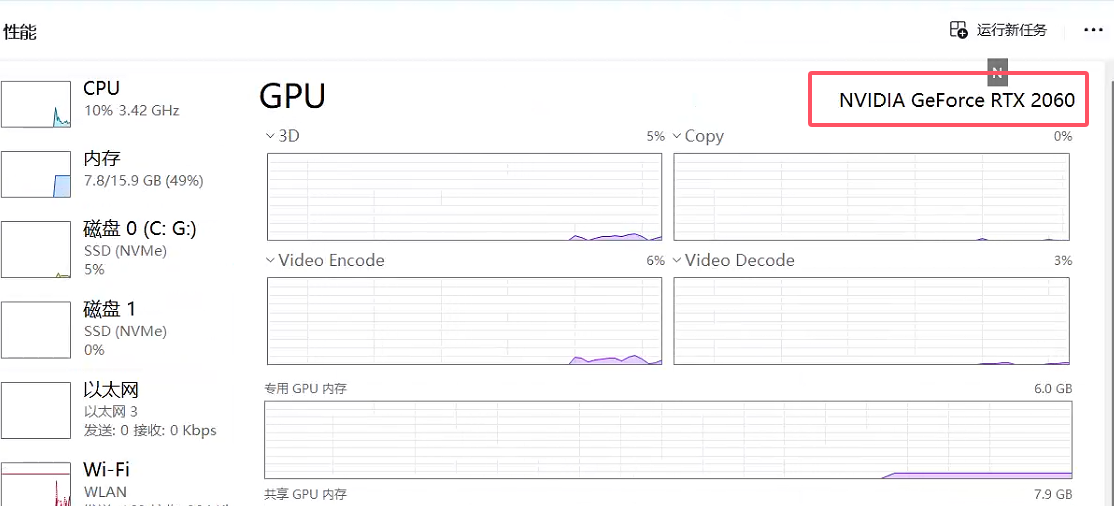

1.1 CUDA版本确认

1.1.1 确认自己的显卡

- (最好是N卡,A卡好像只能使用CPU训练)

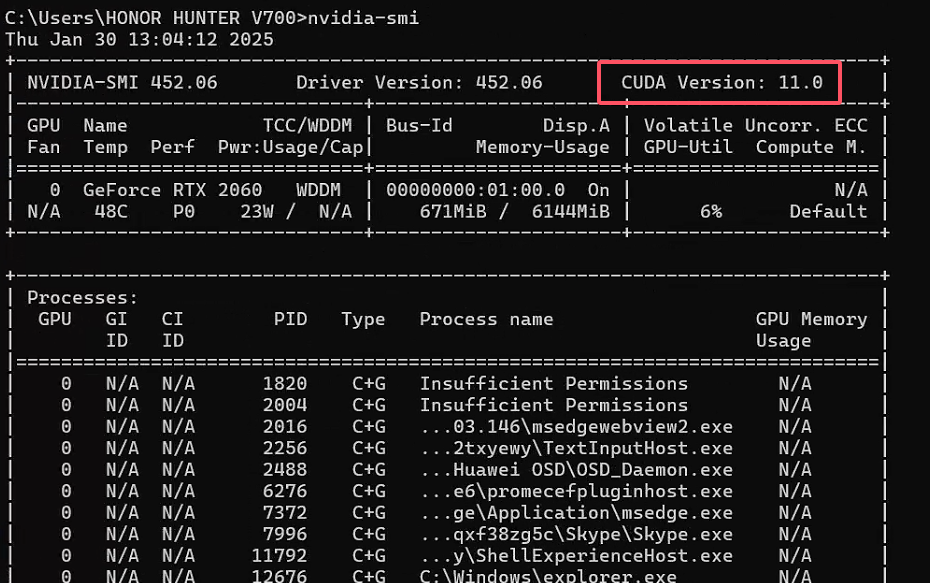

1.1.2 查看CUDA版本

1 | nvidia-smi |

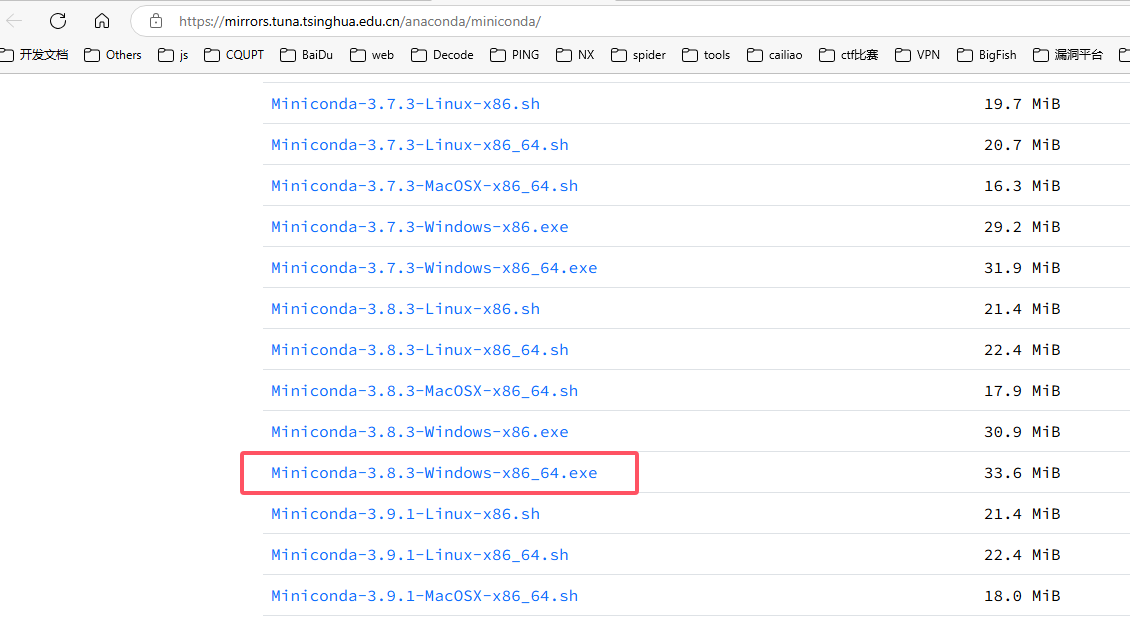

1.2 安装miniconda

1.2.1 下载地址

1 | https://mirrors.tuna.tsinghua.edu.cn/anaconda/miniconda/ |

1.2.2 选择版本

- 可以根据自己后期使用的python版本选择,也可以随便选择

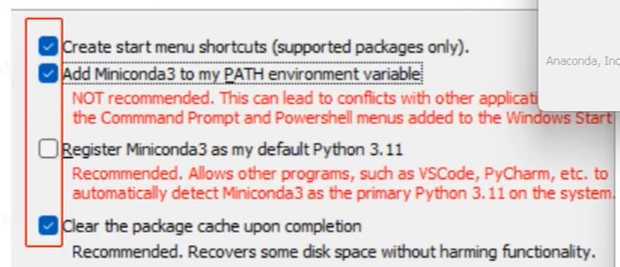

1.2.3 安装

- 记住第三条不勾选,其他勾选

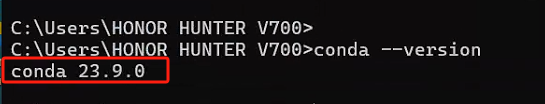

1.2.4 查看是否安装成功

1 | conda --version |

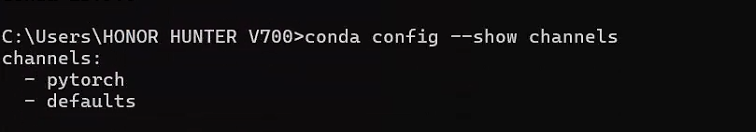

1.3 conda切换源

1.3.1 常用命令

1 | # 查看镜像源 |

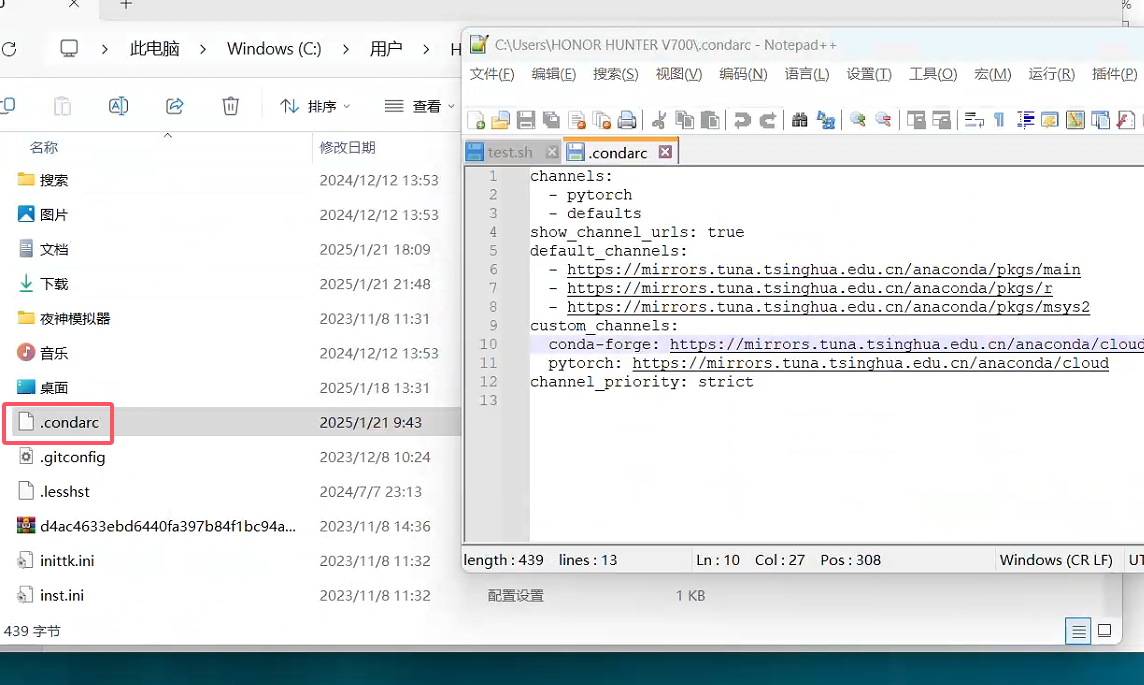

1.3.2 切换清华源

可以查看这里anaconda | 镜像站使用帮助 | 清华大学开源软件镜像站 | Tsinghua Open Source Mirror

将

C:\Users\<YourUserName>\.condarc内容改成下面

1 | channels: |

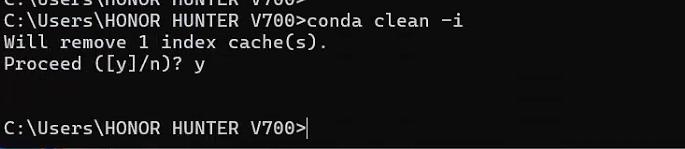

1.3.3 清除索引缓存

1 | conda clean -i |

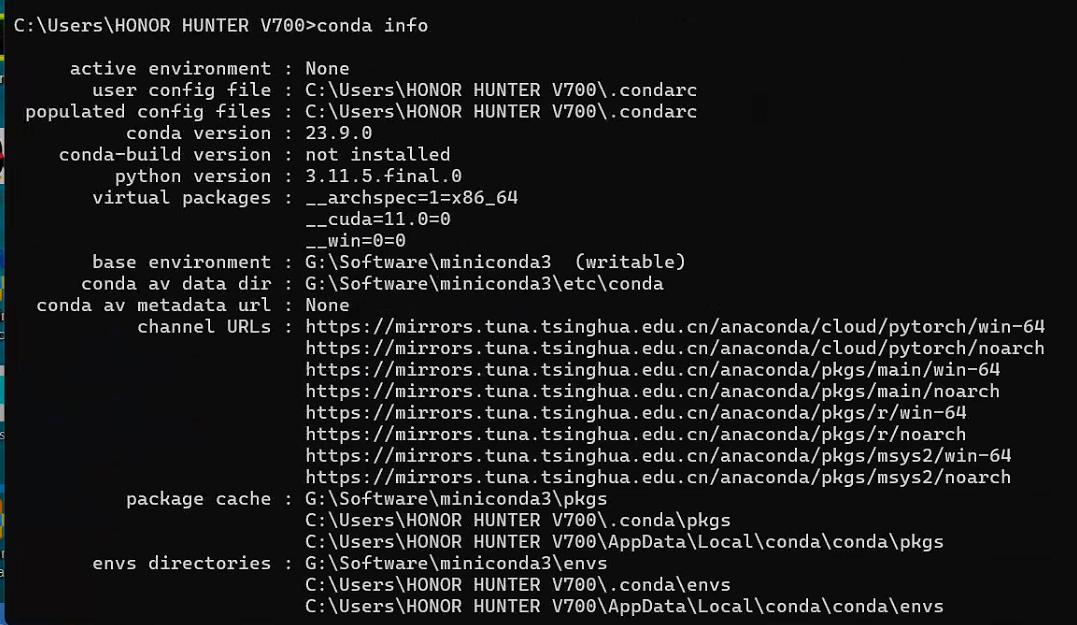

1.3.4 查看安装情况

1 | conda info |

1.4 创建虚拟环境

1.4.1 常用命令

1 | # 查看当前虚拟环境 |

1.4.2 创建虚拟环境

1 | conda create -n yolov11 python=3.8 |

1.4.3 进入虚拟环境

1 | conda activate yolov11 |

1.5 pytorch框架安装

1.5.1 部分对应版本

| torch | torchvision | Python |

|---|---|---|

main / nightly |

main / nightly |

>=3.8, <=3.12 |

2.3 |

0.18 |

>=3.8, <=3.12 |

2.2 |

0.17 |

>=3.8, <=3.11 |

2.1 |

0.16 |

>=3.8, <=3.11 |

2.0 |

0.15 |

>=3.8, <=3.11 |

1.13 |

0.14 |

>=3.7.2, <=3.10 |

1.12 |

0.13 |

>=3.7, <=3.10 |

1.11 |

0.12 |

>=3.7, <=3.10 |

1.10 |

0.11 |

>=3.6, <=3.9 |

1.9 |

0.10 |

>=3.6, <=3.9 |

1.8 |

0.9 |

>=3.6, <=3.9 |

1.7 |

0.8 |

>=3.6, <=3.9 |

1.6 |

0.7 |

>=3.6, <=3.8 |

1.5 |

0.6 |

>=3.5, <=3.8 |

1.4 |

0.5 |

==2.7, >=3.5, <=3.8 |

1.3 |

0.4.2 0.4.3 |

==2.7, >=3.5, <=3.7 |

1.2 |

0.4.1 |

==2.7, >=3.5, <=3.7 |

1.1 |

0.3 |

==2.7, >=3.5, <=3.7 |

<=1.0 |

0.2 |

==2.7, >=3.5, <=3.7 |

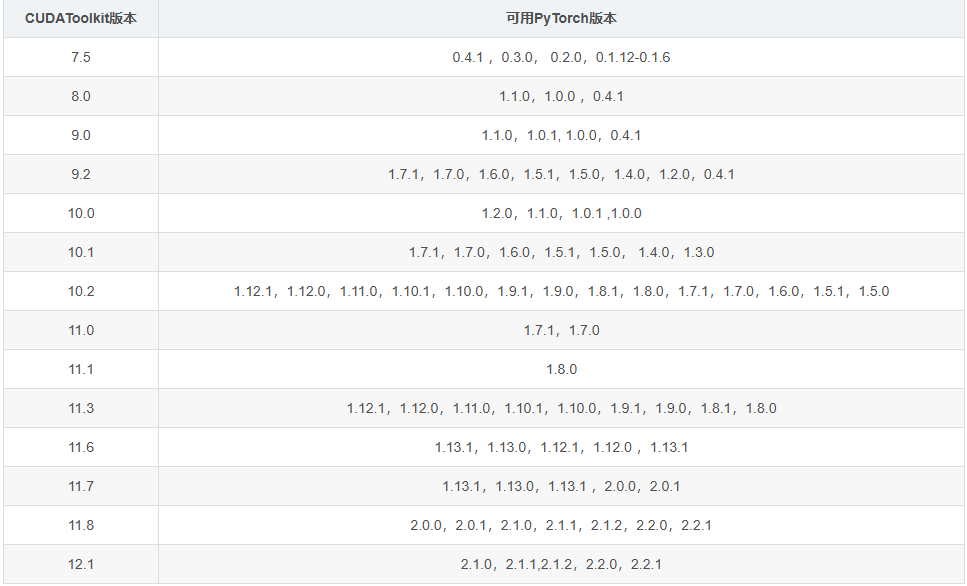

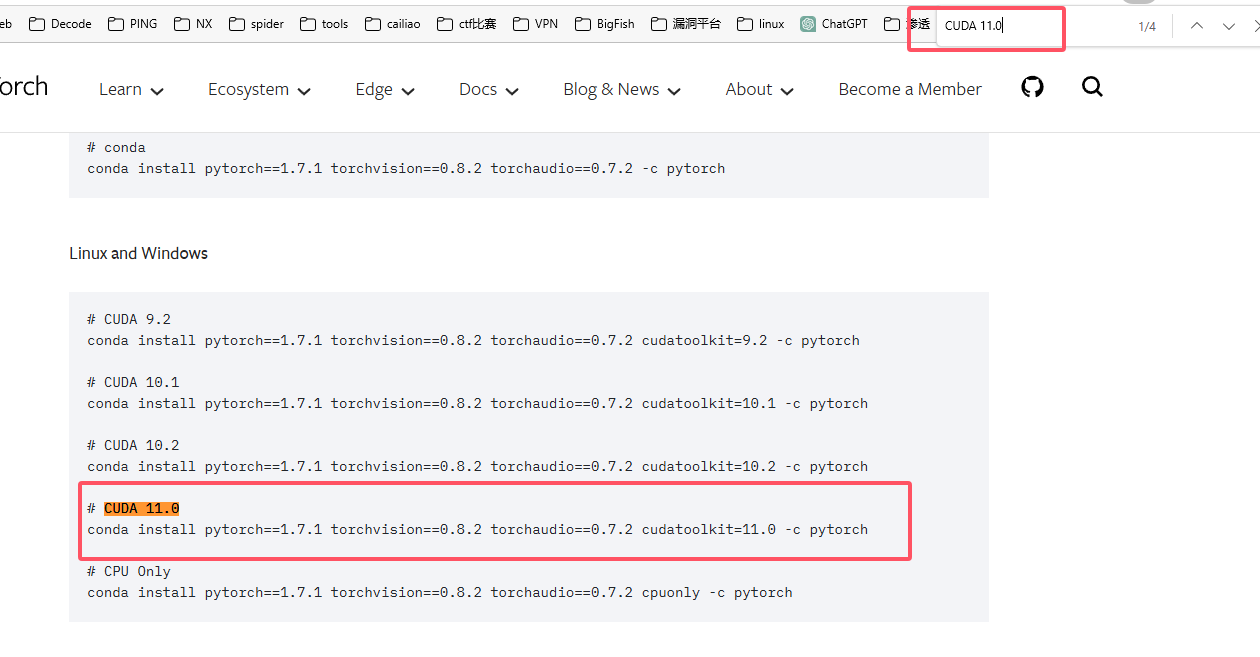

1.5.2 安装pytorach

1.5.2.1 注意

- 因为我的CUDA是

11.0,所以对于的pytorach版本是1.7.1和1.7.0 - 因为

pytorach1.7对应的python版本是3.6 - 3.9,所以我选择python版本是3.8 - 如果你对于的python版本是其他的,则需要在系统环境中将python版本设置为需要版本,且重新创建conda虚拟环境,记得python环境要符合

- 查看conda的python版本

1.5.2.2 pytorch下载地址

1 | https://pytorch.org/get-started/previous-versions/ |

1.5.2.3 下载pytorch

1 | conda install pytorch==1.7.1 torchvision==0.8.2 torchaudio==0.7.2 cudatoolkit=11.0 -c pytorch |

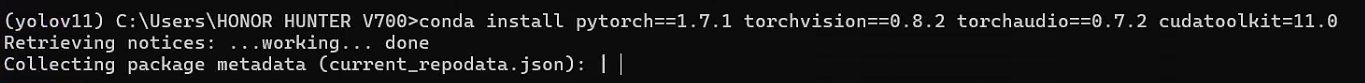

1.5.3 查看安装情况

1 | python |

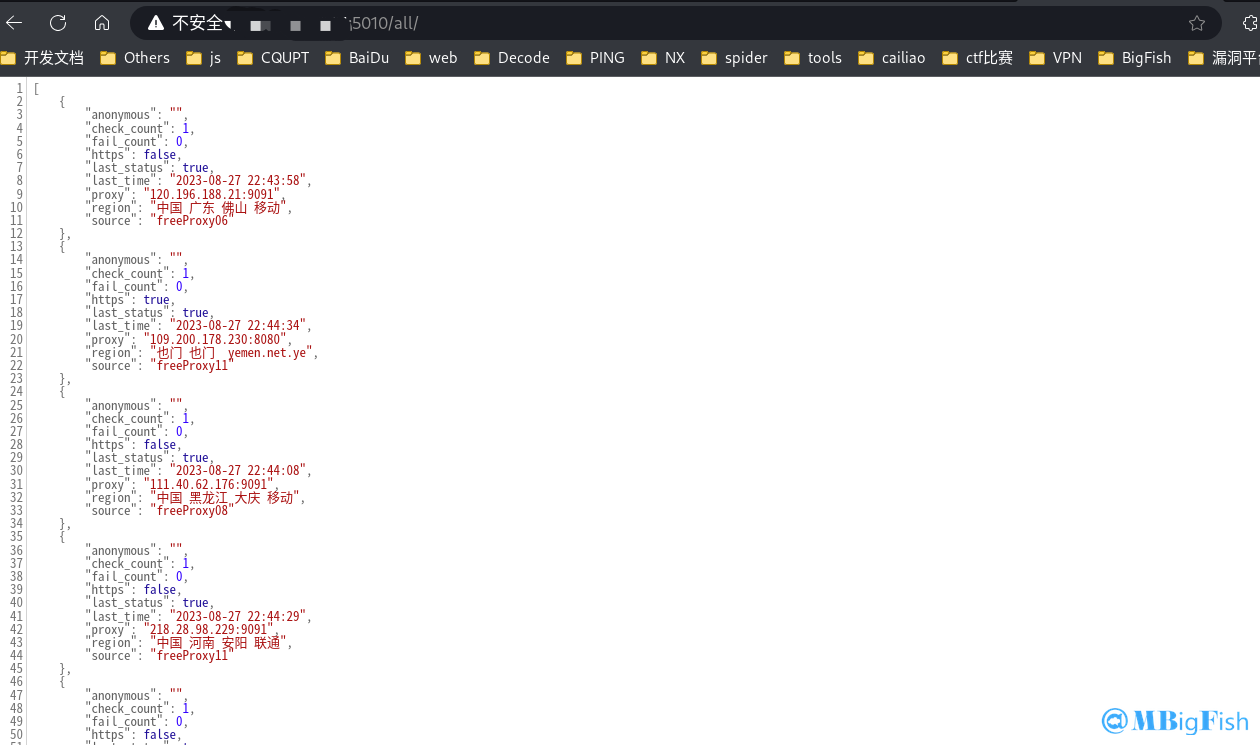

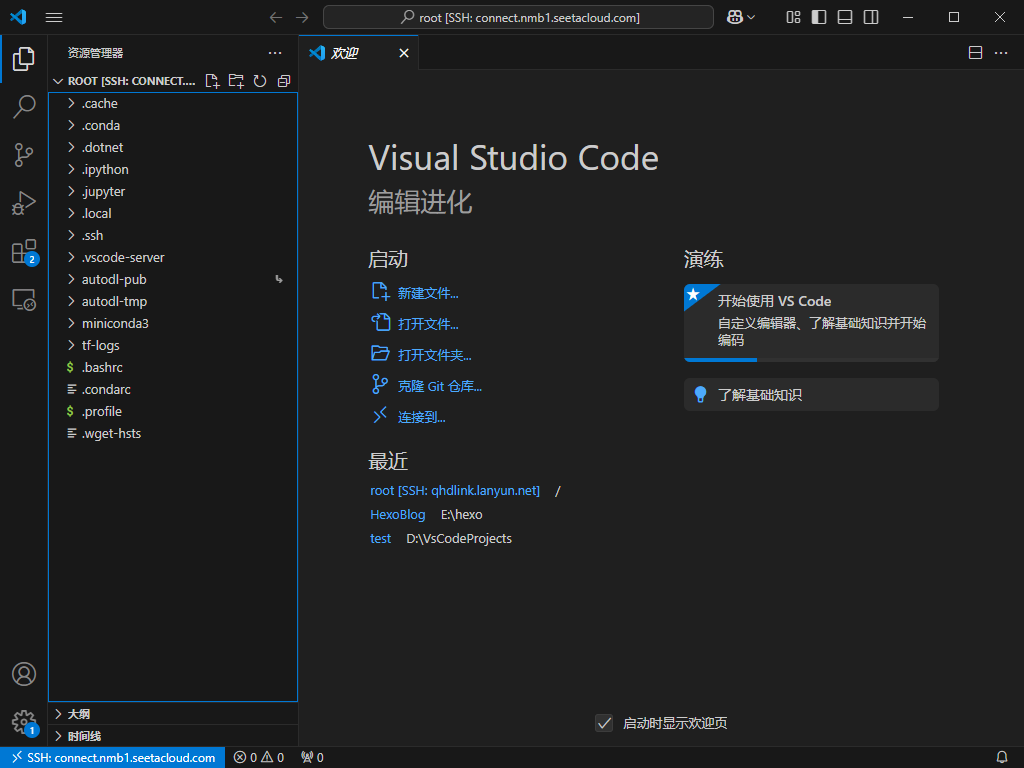

2 云平台部署

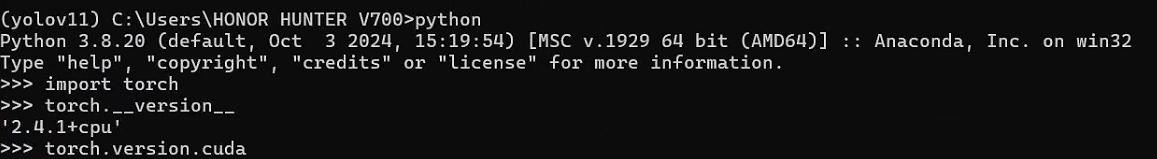

2.1 配置VScode

安装 VSCode 插件,Remote-SSH 、 Chinese (Simplified)

2.2 租用显卡

注意环境版本

2.3 登录云服务

2.4 创建虚拟环境

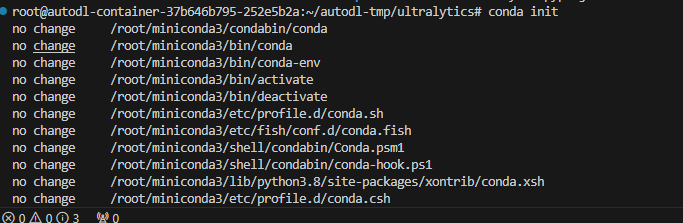

2.4.1 初始化

1 | conda init |

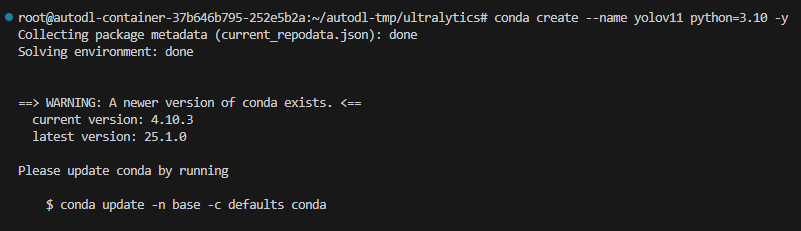

2.4.2 新建环境

1 | conda create --name yolov11 python=3.10 -y |

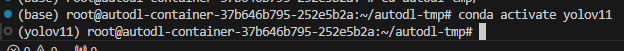

2.4.3 激活环境

- (记得重新打开终端页面)

1 | conda activate yolov11 |

3 开始训练

3.1 准备

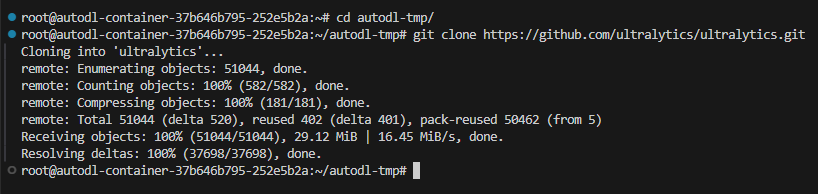

3.1.1 下载代码

1 | git clone https://github.com/ultralytics/ultralytics |

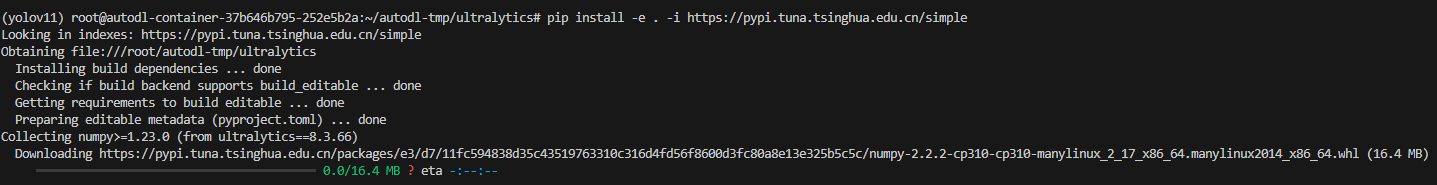

3.1.2 安装环境

1 | pip install -e . -i https://pypi.tuna.tsinghua.edu.cn/simple |

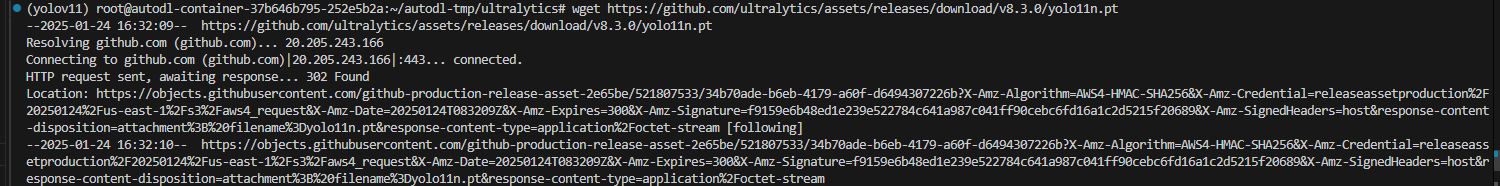

3.1.3 下载权重

1 | wget https://github.com/ultralytics/assets/releases/download/v8.3.0/yolo11n.pt |

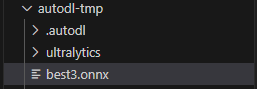

3.1.4 上传文件

- 上传自己准备好的数据集

- 上传后将文件从

autodl-fs移动到autodl-tmp目录下

- 注意训练集文件格式

1 | shujuji |

3.1.4 推理文件

推理模型deletc.py文件

1 | from ultralytics import YOLO |

训练模型train.py文件

1 | from ultralytics import YOLO |

评估模型val.py文件

1 | from ultralytics import YOLO |

模型文件coco1233.yaml

- 文件目录

/root/autodl-tmp/ultralytics/ultralytics/cfg/datasets/coco128.yaml

1 | # Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license |

3.2 训练

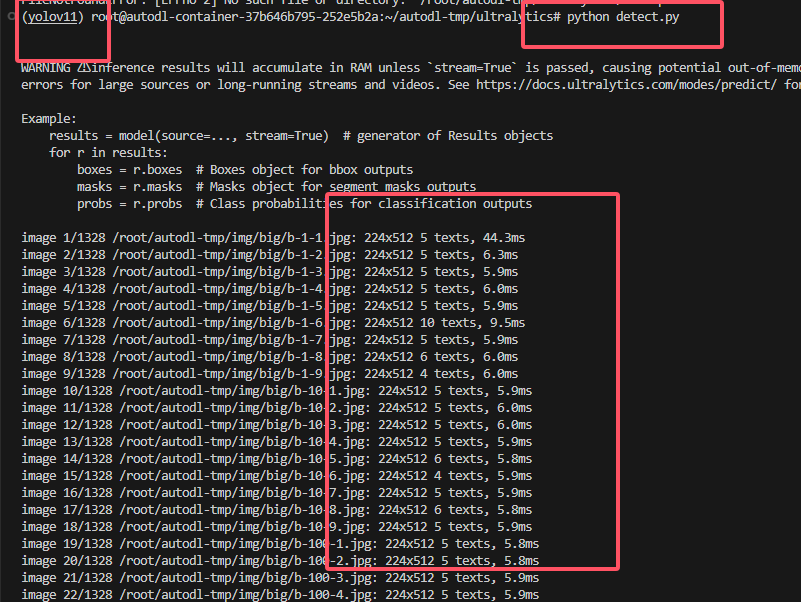

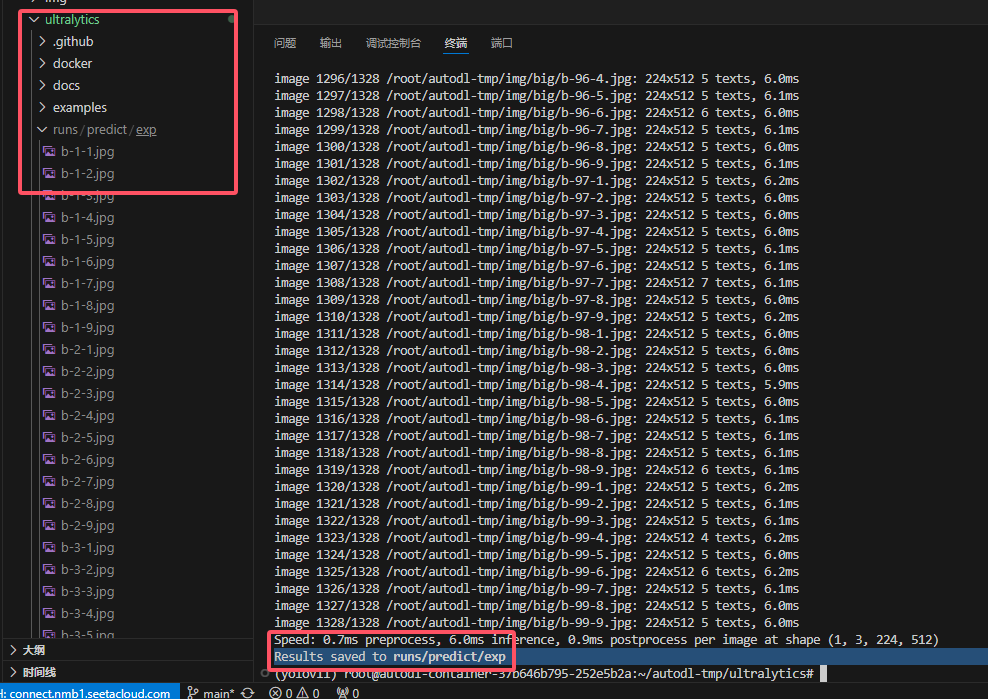

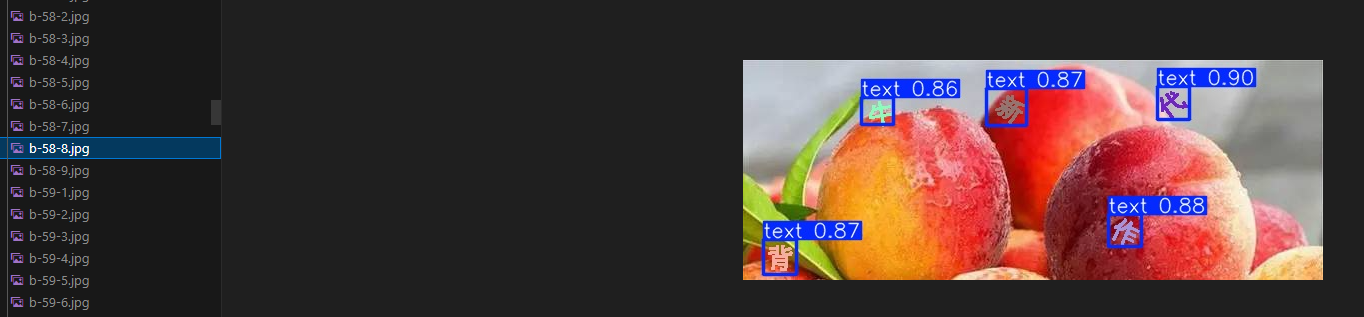

3.2.1 测试模型

1 | python detect.py |

- 测试结果所在文件夹

- 测试情况

3.2.2 训练模型

1 | python train.py |

4 导出使用

4.1 pt文件转成onnx文件

1 | from ultralytics import YOLO |

4.2 使用

1 | import time |

5 补充

5.1 xml转txt(批量)

1 | import os |

参考:

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 大鱼博客!

评论